- Как создать файлы Robots.txt

- Проанализируйте ваш файл Robots.txt

- Пример формата Robots.txt

- Справочная информация о файлах Robots.txt

- Конкретные советы по URL

- Образец Робот Странности

- Noindex вместо Disallow в Robots.txt?

- Защищенная версия вашего сайта индексируется?

- Есть проблемы с каноникализацией или угоном?

- Хотите разрешить индексирование определенных файлов в папке, заблокированных с помощью сопоставления...

- Сравнивая Robots.txt с ...

Как создать файлы Robots.txt

Используйте наш Robots.txt генератор создать файл robots.txt.

Проанализируйте ваш файл Robots.txt

Используйте наш Robots.txt анализатор проанализировать ваш файл robots.txt сегодня.

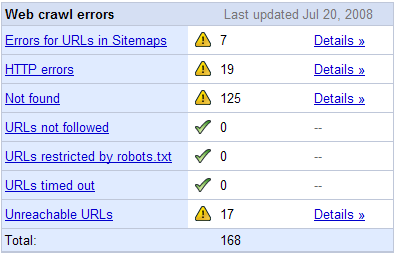

Google также предлагает аналогичный инструмент внутри Google Webmaster Central и показывает ошибки сканирования Google для вашего сайта.

Пример формата Robots.txt

Разрешить индексацию всего

Пользователь-агент: *

Disallow:

или же

Пользователь-агент: *

Разрешать: /

Запретить индексирование всего

Пользователь-агент: *

Disallow: /

Отключить индексирование определенной папки

Пользователь-агент: *

Disallow: / папка /

Запретить Googlebot индексировать папку, за исключением разрешения индексирования одного файла в этой папке

Пользователь-агент: Googlebot

Disallow: / folder1 /

Разрешить: /folder1/myfile.html

Справочная информация о файлах Robots.txt

- Файлы Robots.txt сообщают поисковикам, как взаимодействовать с индексацией вашего контента.

- По умолчанию поисковые системы являются жадными. Они хотят индексировать как можно больше высококачественной информации и предположат, что могут сканировать все, если вы не скажете им иначе.

- Если вы укажете данные для всех ботов (*) и данные для конкретного бота (например, GoogleBot), то будут следовать конкретные команды ботов, в то время как этот движок игнорирует команды ботов global / default .

- Когда вы блокируете URL-адреса от индексации в Google с помощью robots.txt, они все равно могут показывать эти страницы как списки только URL-адресов в своих результатах поиска. Лучшее решение для полной блокировки индекса конкретной страницы - использовать метатег noindex для роботов на основе страниц. Вы можете указать им не индексировать страницу или не индексировать страницу и не переходить по исходящим ссылкам, вставив один из следующих битов кода в заголовок HTML вашего документа, который вы не хотите индексировать.

- <meta name = "robots" content = "noindex"> <- страница не проиндексирована, но можно переходить по ссылкам

- <meta name = "robots" content = "noindex, nofollow"> <- страница не проиндексирована и ссылки не переходят

- Обратите внимание, что если вы сделаете и то и другое: заблокируйте поисковые системы в robots.txt и через метатеги, тогда команда robots.txt является основным драйвером, так как они могут не сканировать страницу, чтобы увидеть метатеги, поэтому URL может По-прежнему появляются в результатах поиска, перечисленных только для URL.

- Если у вас нет файла robots.txt, журналы вашего сервера будут возвращать 404 ошибки каждый раз, когда бот пытается получить доступ к вашему файлу robots.txt. Вы можете загрузить пустой текстовый файл с именем robots.txt в корень вашего сайта (то есть: seobook.com/robots.txt ) если вы хотите прекратить получать ошибки 404, но не хотите предлагать какие-либо конкретные команды для ботов.

- Некоторые поисковые системы позволяют вам указывать адрес XML Sitemap в вашем файле robots.txt, но если ваш сайт небольшой и хорошо структурирован с чистой структурой ссылок, вам не нужно создавать XML карту сайта. Для крупных сайтов с несколькими подразделениями, сайтов, которые генерируют огромные объемы контента каждый день, и / или сайтов с быстро меняющимся запасом, XML-карты сайта могут быть полезным инструментом для индексации важного контента и отслеживания относительной эффективности глубины индексации по типу страницы.

Задержка сканирования

- Поисковые системы позволяют устанавливать приоритеты сканирования.

- Google не поддерживает команду задержки сканирования напрямую, но вы можете снизить приоритет сканирования в Google Webmaster Central.

- Вы можете установить Yahoo! Задержка сканирования в файле robots.txt. ( Примечание: на большинстве крупных рынков за пределами Японии Yahoo! Search работает на Bing, а Google поддерживает поиск в Yahoo! Япония).

- Их код задержки сканирования robots.txt выглядит следующим образом

Пользователь-агент: Slurp

Задержка сканирования: 5

где 5 в секундах.

- Их код задержки сканирования robots.txt выглядит следующим образом

- Информация Microsoft для Bing находится Вот ,

- Их код задержки сканирования robots.txt выглядит следующим образом

Пользователь-агент: bingbot

Задержка сканирования: 10

где 10 в секундах.

- Их код задержки сканирования robots.txt выглядит следующим образом

Robots.txt Подстановочные знаки соответствия

Google и Microsoft Bing разрешают использование подстановочных знаков в файлах robots.txt.

Чтобы заблокировать доступ ко всем URL-адресам, содержащим знак вопроса (?), Вы можете использовать следующую запись:

Пользователь-агент: *

Disallow: / *?

Вы можете использовать символ $, чтобы указать соответствие конца URL. Например, чтобы заблокировать URL-адреса, заканчивающиеся на .asp, вы можете использовать следующую запись:

Пользователь-агент: Googlebot

Disallow: /*.asp$

Больше информации о подстановочных знаках доступно от Google а также Yahoo! Поиск ,

Конкретные советы по URL

Частью создания чистого и эффективного файла robots.txt является обеспечение того, чтобы структура вашего сайта и имена файлов создавались на основе разумной стратегии. Какие мои любимые советы?

- Избегайте дат в URL: если в какой-то момент вы хотите отфильтровать архивы на основе дат, то вам не нужны даты в путях к файлам на страницах с обычным контентом, или вы легко можете отфильтровать обычные URL-адреса. Есть множество других причин избегать дат в URL также.

- Конечные URL-адреса с обратной косой чертой : если вы хотите заблокировать короткое имя файла, и у него нет обратной косой черты в конце, тогда вы можете случайно заблокировать другие важные страницы.

- Рассмотрим связанные URL-адреса, если вы используете подстановочные знаки Robots.txt: я случайно стоил мне более 10000 долларов прибыли с одной ошибкой robots.txt!

- Динамическая перезапись URL: Yahoo! Поиск предлагает динамическое переписывание URL , но так как большинство других поисковых систем не используют его, вам, вероятно, лучше переписать свои URL-адреса в файле .htaccess, чем создавать дополнительные переписывания только для Yahoo! Поиск. Google предлагает параметры обработки параметров & отн = каноническое , но, как правило, лучше исправлять общедоступные URL-адреса таким образом, чтобы они были максимально согласованными, чтобы

- если вы когда-нибудь мигрируете между платформами, у вас не будет много случайных ссылок, указывающих на страницы, которые больше не существуют

- вы не заканчиваете тем, что разрабатываете сложный лабиринт, когда меняете платформы на протяжении многих лет

- Сайты на разных рынках и языках. Поисковые системы обычно стараются повысить рейтинг известных локальных результатов, хотя в некоторых случаях бывает сложно встроить ссылки во многие локальные версии сайта. Google предлагает hreflang чтобы помочь им узнать, какие URL являются эквивалентами для разных языков и рынков.

- Дополнительные советы по URL в именование файлов раздел нашего Программа обучения SEO ,

Образец Робот Странности

Google создает страницы поиска на вашем сайте?

Google начал вводить поисковые фразы в формы поиска, что может привести к потере PageRank & вызвал некоторые проблемы с дублированием контента , Если у вас недостаточно прав доступа к домену, возможно, вы захотите запретить Google индексировать URL-адрес вашей страницы поиска. Если вы не уверены в URL своей поисковой страницы, вы можете выполнить поиск на своем сайте и посмотреть, какой URL появляется. Например,

- URL поиска Wordpress по умолчанию обычно ? S =

- Добавление

Пользователь-агент: *

Disallow: /? S =

в ваш файл robots.txt не позволит Google создавать такие страницы

- Добавление

- Drupal поддерживает сайт SEO Book, и наш поисковый URL по умолчанию для Drupal - / search / node /

Noindex вместо Disallow в Robots.txt?

Обычно директива noindex включается в тег meta robots. Тем не менее, Google уже много лет поддержали используя noindex внутри Robots.txt Точно так же, как веб-мастер использовал бы запрет.

Пользователь-агент: Googlebot

Disallow: / page-uno /

Noindex: / page-uno /

Улов, как заметил Sugarrae , - это URL-адреса, которые уже проиндексированы, но в robots.txt установлены значения noindex, что приведет к ошибкам в поисковой консоли Google (ранее известной как Инструменты Google для веб-мастеров). Джон Мёллер из Google также рекомендуется против используя noindex в robots.txt.

Защищенная версия вашего сайта индексируется?

В этом гостевом посте Тони Спенсер о 301 перенаправления и .htaccess он предлагает советы о том, как предотвратить индексацию вашей версии SSL https на вашем сайте. За годы, прошедшие с момента первоначального опубликования, Google указывал на то, что рейтинг HTTPS-версии сайта предпочтительнее, чем HTTP-версии сайта. Есть способы выстрелить себе в ногу, если она не перенаправлена или не канонизирована должным образом.

Есть проблемы с каноникализацией или угоном?

На протяжении многих лет некоторые люди пытались угнать другие сайты используя гнусные приемы с веб-прокси. Google , Yahoo! Поиск , Microsoft Live Search , а также Просить все позволяют владельцам сайтов аутентифицировать своих ботов.

- Хотя я полагаю, что Google исправил угон прокси прямо сейчас, хорошим советом, чтобы минимизировать любые риски угона, является использование абсолютных ссылок (таких как <a href="http://www.seobook.com/about.shtml">), а не относительных ссылки (<a href="about.shtml">).

- Если и WWW и не WWW версии вашего сайта индексируются, вы должны 301 перенаправление менее авторитетная версия для более важной версии.

- Версия, которая должна быть перенаправлена, является той, которая не ранжируется также для большинства поисковых запросов и имеет меньше входящих ссылок.

- Сделайте резервную копию вашего старого файла .htaccess перед его изменением!

Хотите разрешить индексирование определенных файлов в папке, заблокированных с помощью сопоставления с образцом?

Разве мы не хитрый!

Первоначально robots.txt поддерживал только директиву disallow, но некоторые поисковые системы также поддерживают директиву allow. Директива allow плохо документирована и может обрабатываться разными поисковыми системами по-разному. Семетрическая информация о как Google обрабатывает директиву allow , Их исследование показало:

Количество символов, которые вы используете в пути директивы, имеет решающее значение при оценке Разрешить против Запрета. Правило, чтобы управлять ими все следующее:

Соответствующая директива Allow бьет соответствующий Disallow, только если она содержит больше или равное количество символов в пути

Сравнивая Robots.txt с ...

ссылка rel = nofollow и мета-роботы Noindex / Nofollow Tags

Просканировано роботом Googlebot?

Появляется в указателе?

Потребляет PageRank

Риски? Отходы?

Формат robots.txt нет Если документ связан с, он может отображаться только по URL или с данными из ссылок или надежных сторонних источников данных, таких как ОРС да

Люди могут просмотреть ваш файл robots.txt, чтобы увидеть, какой контент вы не хотите индексировать. Многие новые запуски обнаруживаются людьми, которые следят за изменениями в файле robots.txt.

Неправильное использование подстановочных знаков может быть дорогим !

Пользователь-агент: *

Disallow: / папка /

ИЛИ ЖЕ

Пользователь-агент: *

Disallow: /file.html

Сложные подстановочные знаки также могут быть использованы.

тэг robots meta noindex да нет да, но может передавать большую часть своего PageRank путем ссылки на другие страницы

Ссылки на странице noindex все еще сканируются поисковыми пауками, даже если страница не отображается в результатах поиска (если они не используются вместе с nofollow).

Страница, использующая роботы meta nofollow (1 строка ниже) в сочетании с noindex, может накапливать PageRank, но не передавать его другим страницам.

<meta name = "robots" content = "noindex">

ИЛИ можно использовать с Nofollow Likeo

<meta name = "robots" content = "noindex, nofollow"> целевая страница тега meta nofollow роботов сканируется только в том случае, если ссылка на страницу назначения из других документов отображается только в том случае, если ссылка на страницу из других документов отсутствует, PageRank не передается в пункт назначения Если вы нажимаете значительный PageRank на страницу и не позволяйте PageRank вытекать с этой страницы, вы можете потерять значительный капитал ссылки.

<meta name = "robots" content = "nofollow">

ИЛИ можно использовать с noindex likeso

<meta name = "robots" content = "noindex, nofollow">

ссылка rel = nofollow конечная страница сканируется только в том случае, если ссылка на нее из других документов конечная страница отображается только в случае ссылки на другие документы. Использование этого может привести к потере некоторого PageRank. Рекомендуется использовать в пользовательских областях контента. Если вы делаете что-то пограничный спам и используете nofollow для внутренних ссылок для создания PageRank, то вы больше похожи на SEO и с большей вероятностью будете наказаны инженером Google за «поисковый спам» <a href = "http: // destination .com / "rel =" nofollow "> текст ссылки </a> rel = canonical yes. несколько версий страницы могут быть просканированы и могут отображаться в индексных страницах, все еще отображаться в индексе. это воспринимается как подсказка, а не директива. PageRank должен накапливаться в целевой точке назначения. С помощью таких инструментов, как перенаправления 301 и rel = canonical, может быть небольшое количество утечки PageRank, особенно с rel = canonical, поскольку обе версии страницы остаются в поисковом индексе.

<link rel = "canonical" href = "http://www.site.com/great-page" />

Ссылка на Javascript, как правило, да, если целевой URL легко доступен в разделах href или onclick целевой страницы ссылки, отображается только в том случае, если ссылки на другие документы обычно да, PageRank обычно передается в пункт назначения, хотя многие из них следуют Google , они не могут сопровождаться другими поисковыми системами.

- <div onclick = "document.location.href = 'http: //foo.com/'">

- <tr onclick = "myfunction ('index.html')"> <a href = "#"

onclick = "myfunction ()"> новая страница </a> - <a href = "javascript: void (0)" onclick = "window.open

('welcome.html') "> открыть новое окно </a>

Похожие

Robots.txt - вот как это делается... Robots.txt. Мы хотим посмотреть, как создать Robots.txt, как избежать наиболее распространенных ошибок и какие есть альтернативы. Но прежде чем я начну, позвольте мне объяснить несколько основ. Robots.txt - Что это? С Robots.txt у веб-мастера есть возможность определить, какие подстраницы и каталоги его сайта не будут проиндексированы поисковыми системами. Существует множество причин, по которым страницы или каталоги исключаются из индексации. Например, не следует индексировать 5 проверенных способов оптимизации Google Panda

... сайта. Все мы знаем, что очень многие веб-сайты потеряли свой драгоценный рейтинг мгновенно, в то время как некоторые другие постепенно отказались и утонули в игре с рейтингом. Если вы похожи на большинство людей, вы можете подумать, как мне оптимизировать мой блог; веб-страницы и опубликовать, пожалуйста, Google? В этой статье я хочу поделиться с вами некоторыми проверенными способами начать работу. Это не моя идея, но творчество, стоящее за этим, полностью мое. Как создать XML и HTML Sitemaps для вашего сайта WordPress

... во людей слышали, что им нужна карта сайта, поэтому Google понравится их сайт, но каков он и как вы собираетесь его создать"> Большинство людей слышали, что им нужна карта сайта, поэтому Google понравится их сайт, но каков он и как вы собираетесь его создать? Файлы Sitemap рекомендуются для оптимизации поисковых систем, чтобы помочь Google (и другим поисковым системам) обнаружить весь контент на вашем сайте. Поисковые системы обычно обнаруживают контент на вашем сайте, следуя всем Google Places SEO - поисковая оптимизация Google Places

... сть в список Google Maps (официально известный как Google Places), на первой странице поиск по географическим регионам может стать проблемой, если вы не знакомы с тем, что делает хороший список, а что плохой. Здесь, в Superior Internet Marketing, мы точно знаем, что нужно для того, чтобы вы заняли первое место в системе карт Google. Из-за доминирующего визуального местоположения в результатах поиска Google, Google Карты могут оказать значительное влияние на вероятность того, что пользователь SEO копирайтинг: писать для людей или для поисковых систем?

Каждый хочет получить оценку в поисковых системах, и мы хотим пойти далеко на это. Вот почему мы пишем лучше для поисковых систем, чтобы набрать как можно больше баллов? Если мы хотим узнать разницу между написанием для людей или для поисковых систем, мы можем сначала спросить себя, как люди на самом деле читают, когда они читают текст в Интернете, и как поисковые системы «читают». Как люди читают? Исследования показали, что наши глаза делают F-образное движение, SEO Учебник для начинающих

Предисловие - SEO для Вас? Если вы уже являетесь опытным SEO, эта страница не для вас! Это руководство предназначено для людей, которые хотят заниматься SEO (поисковая оптимизация), но обеспокоены тем, что SEO слишком сложен, и им кажется, что им нужно нанять профессионала для этой работы. Неправильно! SEO Советы для фотографов

... сайта абсолютно поможет вам увеличить количество поисковых запросов, темп будет зависеть от нескольких факторов, включая возраст вашего сайта. Без лишних слов, вот шаги, которые я предпринял для оптимизации моего сайта за 350 долларов. 1. Получить SEOquake для вашего браузера Первый шаг, который вам нужно сделать, это загрузить SEOquake , Это бесплатный плагин для Chrome и Mozilla, который позволяет вам видеть сайты SEO: 5 советов по улучшению вашего позиционирования в Google

... вас нет большого бюджета для инвестиций в цифровой маркетинг, знайте, что вы можете улучшить свое размещение в Google в обычном поиске, чтобы увеличить количество посещений вашего сайта"> Если у вас нет большого бюджета для инвестиций в цифровой маркетинг, знайте, что вы можете улучшить свое размещение в Google в обычном поиске, чтобы увеличить количество посещений вашего сайта. Это возможно благодаря стратегии под названием SEO (поисковая оптимизация). SEO - это стратегия, которая Как убрать эффект спам-обратных ссылок с помощью Google Disavow Tool

... самых долгожданных и обсуждаемых функций со времени выхода обновления Penguin. Прежде чем я расскажу об этом дополнении от команды веб-мастеров Google, давайте немного путешествуем во времени. Еще в апреле (2012), когда Google запустил Обновление Google Penguin , серьезное обновление после Изменение алгоритма Panda Как я могу удалить URL на моем сайте из индекса Google?

Чтобы удалить конкретный URL (например, страницу http://www.example.com/page4.html) вашего собственного сайта из индекса Google, доступны две опции: Добавьте роботов метаэлементов в исходный код страницы, которая не должна появляться в индексе, и установите значение NOINDEX. Если добавить следующее к исходному коду страницы, оно будет удалено из индекса: <meta name = "robots" content = "noindex"> Вы должны добавить метаэлемент в область <head> Лучшие 5 плагинов SEO для WordPress 2018: улучшите SEO вашего сайта с помощью этих плагинов

SEO - это один из самых важных аспектов, который нельзя игнорировать, если вы хотите, чтобы ваш сайт

Комментарии

У вас есть свои советы по созданию отличного контента, улучшению SEO сайта, продвижению вашего контента или общению с другими блоггерами?У вас есть свои советы по созданию отличного контента, улучшению SEO сайта, продвижению вашего контента или общению с другими блоггерами? Смущены чем-то, что мы здесь написали? Расскажите нам свои мысли в комментариях! Вы хотите узнать больше об интернет-магазине SEO и о том, как сделать ваш сайт пригодным для поисковых систем?

Вы хотите узнать больше об интернет-магазине SEO и о том, как сделать ваш сайт пригодным для поисковых систем? Тогда узнайте об одном из моих онлайн-семинаров и семинаров по маркетингу >> ЗДЕСЬ << ! 2. Дублированный контент Классика - проблема дублированного контента. Не только в интернет-магазинах, но и, в частности, здесь, потому что различные функции продукта на отдельных URL-адресах могут быстро привести к появлению Например, имеет ли смысл включать в URL некоторые «стоп-слова», такие как «как», «для» или «есть»?

Например, имеет ли смысл включать в URL некоторые «стоп-слова», такие как «как», «для» или «есть»? Если мы ищем интересные ключевые слова, которые должны быть рядом друг с другом, а не на самом деле. К счастью, вы также можете настроить их в WordPress индивидуально. Постоянная ссылка автоматически считывается из основного заголовка и отображается там непосредственно под ним. Просто нажмите [Редактировать], создайте новую структуру (без настройки и подтвердите нажатием [OK]. По мере того, как Google становился все умнее, его сеть была проиндексирована (полностью исключена из Google), а также его бизнес-стратегия, клиенты и их компании?

По мере того, как Google становился все умнее, его сеть была проиндексирована (полностью исключена из Google), а также его бизнес-стратегия, клиенты и их компании? Ушел. Что он понял из всего этого спама? Стратегии «черной шляпы» могут создавать некоторые краткосрочные положительные эффекты, но долгосрочные эффекты могут быть вредными для веб-сайта и бизнеса. Основная цель Google состоит в том, чтобы сделать Интернет более удобным для пользователей, и заполнение его спамом, который возвращает Вы уже предоставили это, если у вас есть блог на вашем сайте; но делает ли ваш блог все возможное, чтобы помочь увеличить видимость и посещаемость вашего сайта?

Вы уже предоставили это, если у вас есть блог на вашем сайте; но делает ли ваш блог все возможное, чтобы помочь увеличить видимость и посещаемость вашего сайта? В этой статье я дам вам 5 простых советов, которые помогут вашим постам в блоге улучшить SEO. Ключевое слово Есть ли у вас какие-либо советы или вопросы по поводу файлов PDF?

Есть ли у вас какие-либо советы или вопросы по поводу файлов PDF? Дайте это знать ниже. В следующей статье блога я буду обсуждать факторы ранжирования Google Scholar и оптимизация научных статей для этой поисковой системы. Но как эти события влияют на то, как Google и другие популярные поисковые системы смотрят ваш сайт?

Но как эти события влияют на то, как Google и другие популярные поисковые системы смотрят ваш сайт? Много было написано о том, должны ли большинство разработчиков начать использовать HTML5 на сайтах своих клиентов. Некоторые, как и я, отвечают громким «да», в то время как другие, похоже, хотят подождать, пока W3C (Консорциум World Wide Web) объявит HTML5 официальным поддерживаемым веб-стандартом. Так каков ответ? К сожалению, нет ответа, и преимущества HTML5 варьируются Хотите узнать, как создавать и продавать отличный контент, который улучшит ваш сайт или блоги SEO?

Хотите узнать, как создавать и продавать отличный контент, который улучшит ваш сайт или блоги SEO? Моя книга - « Блоггинг Smart Way - Как создать и продать блог-убийцу в социальных сетях » - покажу вам, как. Теперь доступно для скачивания. Я покажу вам, как создать и создать блог, который раскачивает Есть ли у компании, у которой есть страница в Facebook или Twitter, рейтинг Google на корпоративном сайте выше?

Есть ли у компании, у которой есть страница в Facebook или Twitter, рейтинг Google на корпоративном сайте выше? Итак, по каким каналам компании должны поддерживать свою поисковую оптимизацию (SEO)? SEO во времена социальных сетей Важность SEO и даже социального SEO часто недооценивают. Мнения пользователей высоко ценятся поисковыми системами, такими как Google, потому Итак, как вы убедитесь, что Google рассматривает ваш контент как сливки урожая?

Итак, как вы убедитесь, что Google рассматривает ваш контент как сливки урожая? Вот почему мы оптимизируем содержание нашего сайта в соответствии с поисковыми целями. Если бы мы создавали видеоурок о том, как создать идеальный дымчатый глаз, мы стремились бы оптимизировать наш контент для женщин, которые готовятся к девичному вечеру, а не для женщин, которые хотят классически выглядеть для своих подружек невесты. Прочитайте больше: Большинство людей слышали, что им нужна карта сайта, поэтому Google понравится их сайт, но каков он и как вы собираетесь его создать?

Большинство людей слышали, что им нужна карта сайта, поэтому Google понравится их сайт, но каков он и как вы собираетесь его создать? Файлы Sitemap рекомендуются для оптимизации поисковых систем, чтобы помочь Google (и другим поисковым системам) обнаружить весь контент на вашем сайте. Поисковые системы обычно обнаруживают контент на вашем сайте, следуя всем ссылкам, которые существуют на вашем сайте, а также на вашем сайте (ваша навигация и т. Д.). Если у вас большой сайт или сайт, имеющий

Txt?

Защищенная версия вашего сайта индексируется?

Есть проблемы с каноникализацией или угоном?

Какие мои любимые советы?

Txt?

Защищенная версия вашего сайта индексируется?

Есть проблемы с каноникализацией или угоном?

Хотите разрешить индексирование определенных файлов в папке, заблокированных с помощью сопоставления с образцом?

Появляется в указателе?

Отходы?